카카오, AI 언어모델 평가 공개

메타·구글보다 한국어 뛰어나

일부 모델 오픈소스 배포 계획

카카오의 초경량 인공지능(AI) 언어 모델인 '카나나 나노(Kanana Nano)'가 기존 중형급 모델과 유사한 수준의 한국어 성능을 갖춘 것으로 입증됐다. 자신감이 붙은 카카오는 카나나 나노의 일부 모델을 오픈소스로 공개할 계획이다. 소형언어모델(SLM) 시리즈에서 잇따라 높은 성능을 입증하면서 저비용 고효율의 AI 모델 기술력을 과시하고 있다.

14일 카카오에 따르면 AI 모델을 개발하는 '카나나 알파' 조직은 지난 10일 테크 블로그에 카나나 나노 성능 평가 결과를 공개했다. 추후 카나나 나노의 6개 모델 중 성능이 좋은 2.1B 모델과 이를 기반으로 한 인스트럭트(Instruct) 모델, 임베딩(Embedding) 모델을 오픈소스로 공개하기로 했다. 카나나 언어모델 전체를 소개하는 테크니컬 리포트도 아카이브에 등록한다.

카나나 나노는 카카오가 지난해 공개한 생성형 AI 카나나 모델의 언어모델 중 가작 작은 용량을 갖춘 SLM이다. 매개변수에 따라 4.5B, 3.1B, 2.1B, 1.3B, 0.6B, 0.4B 등 6개 모델로 구성됐다. 작은 모델들은 모바일 기기에서도 활용할 수 있다.

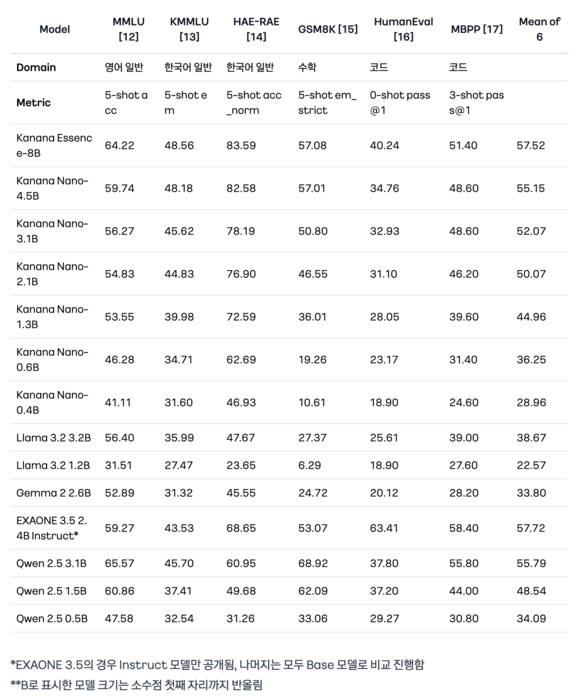

성능평가 결과, 카나나 나노는 크기가 작아진 경량화 모델임에도 불구하고 기존 중형급 모델과 유사한 수준의 높은 한국어 성능을 유지했다. 모바일 환경에서도 쉽게 사용 가능한 아주 작은 크기의 모델까지 유의미한 성능을 기록했다.

구체적으로 카나나 나노는 유사한 크기의 메타의 라마(Llama) 3.2, 구글의 젬마(Gemma) 2 등과 비교해 비슷하거나 우위인 영어 성능과 압도적인 한국어 성능을 달성했다. 특히 '카나나 나노-2.1B'는 크기를 26%로 줄였음에도 불구하고, 중소형 언어모델인 '카나나 에센스(Kanana Essence)'의 93%에 달하는 한국어 성능을 유지했다.

카카오는 카나나 나노 시리즈를 개발하기 위해 AI 모델의 구성 요소를 가지치기해 중요 요소만 남기는 기법인 '프루닝(Pruning)'과 큰 모델의 지식을 더 작은 모델로 전달하는 '증류(Distillation)' 기법을 활용했다. 이 과정에서 기존에 개발을 완료한 카나나 에센스를 경량화 해 적은 데이터로 성능을 극대화하는 방식을 선택했다. 기존 선행 연구는 1~2단계의 모델 압축에 그쳤던 것과 달리 카카오는 모델의 정보 손실을 최소화하며 5~6단계까지 모델을 압축하는 것에 성공했다.

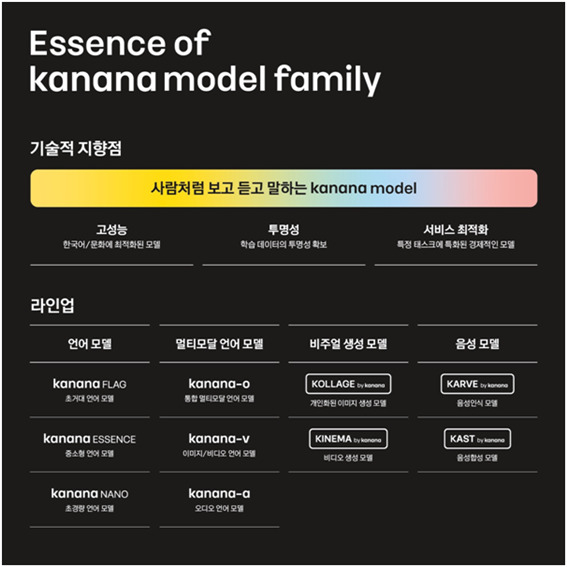

카카오는 지난해 카카오브레인을 본사로 흡수한 이후 AI 연구개발 조직 '카나나'를 신설하고 생성형 AI 모델과 AI 서비스 개발에 속도를 내고 있다. 지난해 10월 개최한 개발자 컨퍼런스 '이프 카카오(if kakao) AI 2024'를 통해 자체 AI 모델인 '카나나 모델'의 라인업을 공개했다. 이후 중소형 언어모델 카나나 에센스, 이미지·비디오 언어모델 '카나나-v(Kanana-v)'의 성능평가 결과를 제시했다. 올해는 카나나 나노에 이어 통합 멀티모달 언어모델인 '카나나-o'의 성능평가 결과를 공개할 계획이다.

변상근 기자 sgbyun@etnews.com