새로운 인공지능(AI) 모델이 등장할 때마다 데이터·비용을 들여 다시 학습해야 하는 것이 현실이다. 이런 가운데, 우리 연구진이 이런 비효율을 해결할 수 있는 AI 모델 간 '지식 이식' 기술을 개발했다.

한국과학기술원(KAIST·총장 이광형)은 김현우 전산학부 교수팀이 고려대 연구팀과 공동연구로, 서로 다른 AI 모델 사이에서 학습된 지식을 효과적으로 이식할 수 있는 기술을 개발했다고 27일 밝혔다.

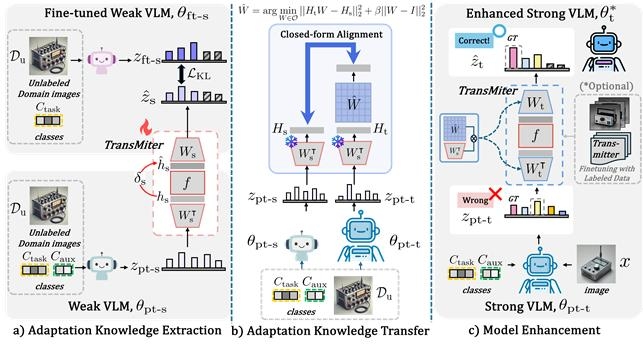

연구팀은 모델 구조·크기에 상관없이 학습 지식을 재사용할 수 있는 '전이 가능한 적응 기법'인 'TransMiter'를 제안했다. 기술 핵심은 한 AI가 학습하며 쌓은 '적응 경험'을 다른 AI 모델로 직접 옮기는 것이다.

AI의 복잡한 내부 구조를 뜯어고치지 않고, 예측 결과만 보고 배운 요령을 다른 AI에게 전해주는 방식이다. 서로 생김새가 다른 AI 모델이라도 같은 질문에 내놓은 답변을 기준으로 정리해 주면, 한 AI가 익힌 노하우를 다른 AI도 바로 활용할 수 있다. 학습 과정을 다시 거칠 필요가 없고, 속도도 거의 느려지지 않는다.

김현우 교수는 “연구를 확장하면, 빠르게 발전하는 초거대언어모델이 등장할 때마다 반복적으로 수행해야 했던 후학습 비용을 크게 줄일 수 있다”며, “특정 분야의 전문 지식을 손쉽게 추가하는 '모델 패치'가 가능해질 것”이라고 설명했다.

연구에는 KAIST 전산학부의 송태훈 석사과정 학생 및 이상혁 박사후연구원, 박지환 고려대 박사과정 학생이 공동 저자로 참여했으며, 김현우 교수가 교신저자를 맡았다. 연구 결과는 AAAI 2026에 구두 발표로 채택돼, 1월 25일 발표됐다.

한편, 김현우 교수 연구실은 이번 논문을 포함해 구글 클라우드 AI와 공동 진행한 '문서내 테이블 이해 고도화 기술' TabFlash 포함해 해당 학회에 총 3편 논문을 발표했다.

이번 연구는 국방기술진흥연구소 산학연 주관 핵심기술 연구개발사업과 정보통신기획평가원(IITP) 디지털혁신기술 국제공동연구사업 지원을 받아 수행됐다.

김영준 기자 kyj85@etnews.com