백승렬 UNIST 교수팀 AI모델 'BIGS' 개발

두 손으로 사물을 조작하는 영상을 3D로 복원하는 인공지능(AI) 기술이 개발됐다. 다양한 의료기구를 사용하는 수술 장면도 정확하게 증강현실(AR) 화상으로 재현한다.

울산과학기술원(UNIST)은 백승렬 인공지능대학원 교수팀이 단일 영상을 토대로 양손과 사물 간 복잡한 상호작용을 실시간 3D로 시각화하는 AI모델 'BIGS(Bimanual Interaction 3D Gaussian Splatting)'를 개발했다고 9일 밝혔다.

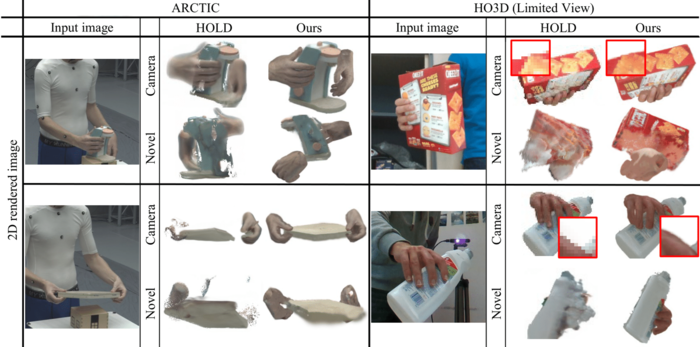

BIGS는 가려지거나 일부만 보이는 영상도 전체를 예측해 복원한다. 단 한 대의 카메라로 찍은 단일 영상만으로 이 같은 복원이 가능하다.

기존 3D 복원 기술은 한 손만 인식하거나 사전에 입력된 사물에만 대응할 수 있어 정확하고 현실감 있는 상호작용 장면을 재현하기 어려웠다.

백 교수팀은 3D 가우시안 스플래팅을 활용해 이 같은 문제를 극복했다. 가우시안 스플래팅은 사물의 형상을 퍼지는 점 구름 형태로 표현하는 기술이다. 픽셀 단위로 경계를 표출하는 기존 포인트 클라우드 기술과 달리 손과 물체가 만나는 접촉면 등을 더 자연스럽게 복원할 수 있다.

손이 겹치거나 일부가 가려진 장면은 기준 손구조에 맞춰 정렬하고, 사전 학습한 확산 모델을 토대로 잘 보이지 않는 사물의 뒷면까지 복원한다.

이번 연구 성과를 담은 논문은 오는 6월 11일~15일까지 5일간 미국에서 열리는 컴퓨터 비전 컨퍼런스 'CVPR 2025'에 채택됐다.

백승렬 교수는 “VR·AR 콘텐츠 개발, 로봇 제어, 원격 수술 시뮬레이션 등 다양한 분야에서 실시간 상호작용 복원 기술로 활용할 수 있을 것”이라고 말했다.

울산=임동식기자 dslim@etnews.com