2022년 하반기 챗GPT의 등장으로 인공지능(AI) 서비스 구현을 위한 핵심으로 AI반도체에 대한 관심이 폭발적이다.

그 중심에는 GPU로 알려져 있는 AI반도체를 세계에서 가장 잘 구현하고 있는 엔비디아가 있다. 엔비디아 GPU는 당초 그래픽 처리에 활용하기 위해 개발됐다. 직렬 처리 방식을 이용하는 CPU와 달리 병렬 처리 방식으로 여러 개 연산을 동시에 처리할 수 있다.

최근 AI 연산용으로 GPU를 많이 사용하는 이유는 그래픽 처리와 AI 연산이 비슷한 방법으로 이뤄지기 때문이다. 쉽게 표현하자면 CPU는 아주 어려운 연산을 빨리 풀어내는 데 장점이 있는 반면 GPU는 CPU보다는 덜 똑똑하지만 단순한 정보를 동시에, 빠르게 연산하는 데 특장점이 있다.

이것이 엔비디아가 AI 시장에서 대체불가 최강자로 떠오르게 된 결정적 이유다.

◇메모리 반도체, AI 반도체 수호천사가 되다.

챗GPT 등 생성형 AI는 대량의 데이터를 학습하고 이를 통해 추론한 결과를 도출한다. 생성형 AI 서비스를 위해서는 두가지 기능이 필요하다. 데이터 학습과 추론을 위한 '연산' 기능과 연산에 필요한 대규모 데이터 저장 및 처리를 포함한 데이터 '조달' 기능이다.

이 두 가지 기능을 얼마만큼 빠르고 효과적으로 처리하느냐가 AI 모델의 성능을 결정하는 요인이다. 초거대 AI의 등장으로 대량의 데이터 조달이 시스템 성능에 핵심 요소로 작용하며 메모리 반도체 중요성이 높아지고 있는 것이다.

메모리 반도체는 PC, 서버 등에 보편적으로 사용되는 범용 D램인 DDR과 모바일 기기 수요 중심의 저전력 D램(Low Power DDR)이 주류 제품으로 기존 시장을 양분하고 있었다.

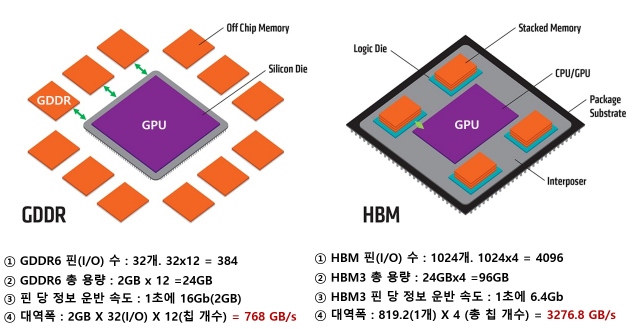

최근 AI 연산 증가로 인해 병렬처리에 강한 특성을 갖지만 전력소모가 많은 GDDR(그래픽스 DDR)과 고대역폭 메모리로 고성능·병렬 연산에 최적화돼 있는 HBM이 시장에 등장해 시장점유율을 확대해 나가고 있다.

그럼 기존 메모리와 HBM은 어떤 차이점이 있을까? 우선 메모리 성능을 보여주는 지표로는 용량(저장할 수 있는 데이터 크기)과 대역폭(데이터를 전송할 수 있는 전송 통로 수) 등이 주요 성능 지표로 활용된다.

D램 용량은 2기가바이트(GB), 대역폭은 32비트(bit) 수준으로, 정보 이동 통로인 핀 개수가 32개로 제한적이어서 병목현상이 발생하는 문제점을 안고 있었다.

이런 문제를 해결하기 위해 D램 여러 개를 수직으로 연결해 기존 D램보다 데이터 처리속도를 대폭 개선한 메모리가 HBM이다.

HBM은 평면에 2개 이상 D램 칩을 구성한 후 이를 TSV(Through Silicon Via) 공정을 통해 쌓아가는 방식으로 기존 32bit 전송 통로를 1024bit로 증가시킨 메모리 반도체다.

기존 평면형 D램에 비해 적층 구조로 제작돼 대용량 AI 연산에 최적화됐다. 보통 GPU는 4개 HBM을 활용하기 때문에 4096개 전송 통로가 확보돼 전송속도의 혁신적 개선이 가능하게 되는 것이다.

이렇게 기존 D램의 단점을 극복한 HBM은 엔비디아, AMD 등 굴지 시스템 반도체 설계회사의 최신 반도체에 적용되면서 그 수요는 점차 확대될 것으로 예상된다.

특히 HBM은 기존 D램보다 3~5배 이상 더 비싼 것으로 알려져 있어 HBM 시장을 양분하고 있는 우리 기업 수익 구조에도 큰 도움이 될 것이다.

◇ 반도체 강국 코리아, 미래를 위한 선제적 연구개발(R&D)에서 출발

지금 '산업의 쌀'이라 불리우는 반도체, 특히 AI반도체 시장 선점을 위한 세계 주요 국가 및 글로벌 빅테크 경쟁이 그 어느때보다 치열한 시점이다.

AI 투자가 심화될수록 HBM과 같은 고성능 메모리 반도체 수요도 함께 늘어날 수밖에 없어 우리나라 메모리 반도체 산업에 긍정적인 영향을 미칠 것으로 전망된다.

이를 적극 활용할수 있도록 경쟁국과의 초격차 유지를 위한 차세대 메모리 기술 확보가 그 어느때보다도 중요한 시점이다.

글:고은영 정보통신기획평가원(IITP) 연구위원