인공지능(AI) 네이티브 검색 강화를 위해 네이버는 내년 인공지능(AI) 고성능 컴퓨팅(HPC) 인프라를 두 배 이상 확장한다. 네이버는 그동안 자체 알고리즘과 뉴럴 매칭 기술로 검색 품질을 끌어올려왔다. AI검색 패권 경쟁 속 네이버는 AI 인프라와 서비스 생태계를 긴밀히 결합해 AI 업체보다 우위를 점할 수 있는 전략을 택했다.

전희재 네이버 AI 고성능 컴퓨팅 리더는 “AI 브리핑 범위가 확대되고 검색 품질 향상을 위한 AI 활용이 늘어나면서 AI HPC가 처리해야 할 연산량과 데이터 규모는 커질 것”이라면서 “네이버는 고속 네트워크 기술과 고성능 분산 스토리지 인프라를 기반으로 내년에는 현재보다 수배 규모로 확장된 AI 컴퓨팅 인프라를 구축할 계획”이라고 말했다.

수천만명이 이용하는 네이버 AI 검색 서비스를 위해서는 이를 안정적으로 구현하고 구동하기 위한 인프라가 필요하다. AI를 활용한 검색이 작동하려면 대규모 연산을 동시에 처리해야 하는 복잡한 AI 모델을 구동해야 하기 때문이다. 네이버는 AI 브리핑 서비스 등을 시행하면서 이미 많은 AI 검색을 처리하고 있는데 내년에는 더 많은 AI 검색 수요에 대응할 인프라를 구축할 계획이다.

전 리더는 “현재 수백대 규모 그래픽처리장치(GPU) 노드에서 수십 종의 AI 모델이 초당 수천건 요청과 수만건 데이터를 실시간으로 처리한다”면서 “AI 브리핑을 비롯해 다양한 검색 서비스의 AI 모델들이 모두 AI HPC 인프라 위에서 운영된다”고 설명했다.

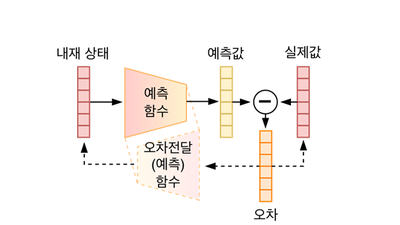

네이버는 검색 서비스 초기부터 자체 알고리즘 개발과 대규모 분산처리 시스템 구축에 집중했다. '벡터 색인(Vector Indexing)'과 함께 2022년 도입한 '뉴럴 매칭(Neural Matching)'이 핵심 기술이다. 뉴럴 매칭은 짧은 질의와 방대한 문서 사이 의미 연관성을 벡터 기반으로 빠르고 정확하게 탐지하는 기술이다. 네이버는 이 기술을 기존 '역색인(키워드)' 기반 검색 엔진에 최적화해 검색 적합성을 약 10% 높였다. 검색 속도 또한 150% 개선했다.

뉴럴 매칭을 대규모 서비스에 적용할 수 있는 기업은 네이버를 포함해 소수 빅테크에 불과하다. 단어 하나를 다차원 벡터로 변환하면 기존 역색인 방식 대비 저장 공간과 연산량이 수십에서 수백배 급증한다. 네이버는 자연어 처리 기술, 언어 자원을 활용해 이 같은 난제를 극복했다.

네이버가 경쟁에서 우위를 점할 수 있다는 평가를 받는 이유는 구글의 배경과 유사하다. 구글은 오픈AI, 퍼플렉시티의 도전으로 경쟁력이 떨어질 수 있다는 진단도 있었지만 검색 인프라와 서비스를 결합해 최근 다시 우위를 확보하고 있다.

구글의 생성형 AI 제미나이는 오픈AI의 챗GPT보다 약 1년 늦게 출시됐음에도 불구하고 월간 활성 사용자 수(MAU) 4억명을 돌파했다. 구글은 AI 모델을 검색 인프라, 유튜브·지메일·워크스페이스 등 서비스 생태계와 연동했다. 네이버 또한 검색과 함께 쇼핑, 지도, 콘텐츠, 사용자 생성 콘텐츠(UGC) 등 일상생활과 밀접한 서비스를 하나의 생태계에서 제공한다.

업계 관계자는 “네이버는 독자 인프라와 AI 기술력을 보유해 외부 기술에 종속될 위험이 적다”면서 “빠르게 변화하는 AI 트렌드에 기민하게 대응할 수 있다는 점에서 AI 에이전트 경쟁에서 네이버가 가진 강점은 더욱 부각될 것”이라고 밝혔다.

변상근 기자 sgbyun@etnews.com