최적화된 인공지능 모델 제공으로 개발 시간 단축 발표

'인공지능 전환(AX) 시대 소형언어모델(sLLM) & 온디바이스 AI 서밋 2024' 이슈 세미나가 지난 28일 서울 송파구 광고문화회관에서 열렸다.

이 행사는 퀄컴CDMA테크놀로지코리아, 인텔코리아와 딥엑스, 포티투마루 등이 참가해 온디바이스 AI 트렌드와 사례 그리고 소형언어모델의 구축 전략을 소개했다.

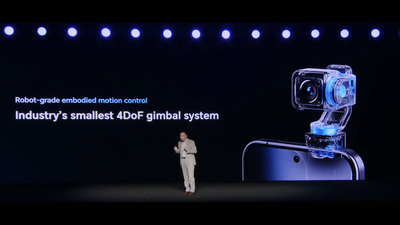

이날 특히 정철호 퀄컴CDMA테크놀로지코리아 상무는 'Generative AI at the edge'라는 주제 발표를 통해 온디바이스 생성형 AI는 더 향상된 응답성, 세밀한 개인화, 높은 안정성 그리고 강화된 프라이버시 기능을 제공할 수 있다며 이와 같은 유용한 컨텍스트와 콘텐츠는 교육이나 의료 같은 부문에서 사용자와 관련성이 높고 특화돼, 개인화된 응답을 제공할 수 있다고 밝혔다.

또 온디바이스 AI는 로컬에서 연산을 수행하므로 지연시간 발생 가능성을 대폭 줄일 수 있고 언제 어디서나 쿼리를 실행할 수 있기 때문에 안정성도 높아진다. 생성형 AI의 채택이 점차 확대되면 기밀 정보, 개인 정보를 비공개로 유지하는 일이 굉장히 중요해지고 온디바이스와 엣지 AI의 핵심 장점인 쿼리와 개인, 고유 정보를 기기(또는 사설 엣지 클라우드를 사용하는 온프레미스 환경)에 유지할 수 있고 분산 컴퓨팅을 활용할 수 있으며, 온디바이스 또는 하이브리드 식으로 더 많은 AI를 처리하면 데이터 센터 비용을 관리하는 데 도움이 된다고 설명했다.

이어 다양한 요건과 컴퓨팅이 요구되는 여러 버티컬에서 생성형 AI 사용 사례에 대한 수요가 증가하고 있고, 이에 따라 AI에 맞춤 설계된 새로운 컴퓨팅 아키텍처에 대한 필요성도 확실해지고 있다면서 이 새로운 아키텍처는 근본적으로 생성형 AI를 위해 설계된 NPU(neural processing unit, 신경망 처리 장치)에서 시작해 동시에 CPU와 GPU 등의 이기종(heterogeneous) 프로세서를 조합해 활용한다고 발표했다.

이기종 컴퓨팅은 NPU와 함께 적절한 프로세서를 사용해 애플리케이션의 성능, 열효율, 배터리 수명 성능을 극대화해 새롭고 더 향상된 생성형 AI 경험을 가능케 한다. 헥사곤 NPU는 동급 최고 수준의 이기종 컴퓨팅 아키텍처인 퀄컴 AI 엔진(Qualcomm AI Engine)의 핵심 프로세서로 해당 엔진은 퀄컴 아드레노(Adreno) GPU, 퀄컴 크라이요(Kryo) 또는 퀄컴 오라이온(Oryon) CPU, 퀄컴 센싱 허브, 그리고 메모리 서브 시스템으로 구성돼 있어 이 프로세서들이 함께 작동해 기기에서 AI 애플리케이션이 빠르고 효율적으로 실행되도록 지원한다고 밝혔다.

마지막으로 정 상무는 “퀄컴 AI 허브는 스냅드래곤 및 퀄컴 플랫폼에75개 이상의 최적화된 AI 모델을 제공해 개발자의 제품 개발 소요 시간을 단축하고 애플리케이션에서 온디바이스 AI 장점을 극대화하며, 최적화된 모델은 현재 퀄컴 AI 허브, 깃허브(GitHub) 및 허깅 페이스(Hugging Face)에서 이용할 수 있다”라고 밝히고 “개발자들은 가입을 통해 간략한 코드로 퀄컴 플랫폼 기반 클라우드 호스팅 기기에서 최적화된 AI 모델을 직접 실행할 수 있고, 퀄컴 AI 허브가 제공하는 최신 기능과 AI 모델을 더욱 빠르게 사용할 수 있으며, 신규 모델이 퀄컴 AI 허브에 지속해 추가될 예정”이라고 강조했다.

정동수 기자 dschung@etnews.com