인공지능(AI)으로 음원을 실시간 분석해 음성을 명확히 전달하거나 배경음악과 대사를 최적화된 음량으로 제공하는 기술이 국내서 개발됐다.

전자부품연구원(KETI)은 26일 AI기반 오디오 음원분석 및 자동 음량 실시간 제어기술을 개발했다고 밝혔다.

방송법에 따라 2016년 5월부터 우리나라 방송프로그램 평균음량은 LKFS(디지털 방송프로그램 음량측정) 기준 (-)24dB로 통일됐다. 압축신호를 송출하는 디지털 방송 특성상 과거 아날로그 방송과 달리 방송국에서 송출신호 조정을 통한 일괄 음량 조절이 어렵기 때문이다.

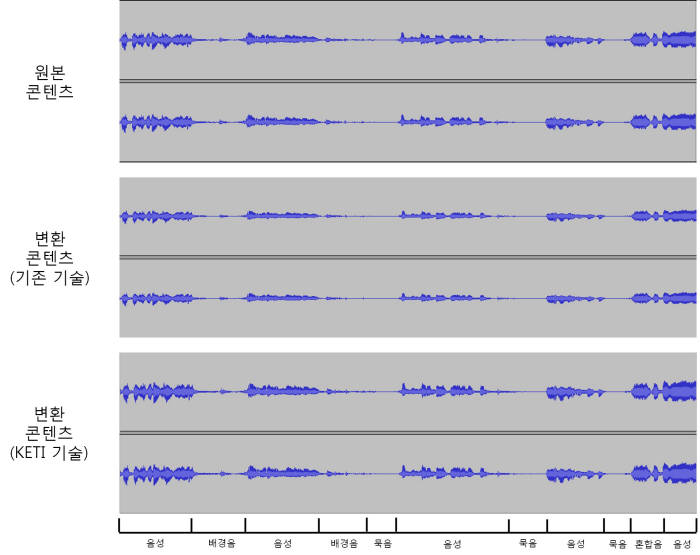

이에 따라 채널 및 프로그램 간 평균 음량 차이가 사라졌다. 하지만 콘텐츠 내에서 들쭉날쭉한 음량편차에 대한 기준이 없어 대사가 잘 안 들리거나 배경음악이 큰 경우가 있었다.

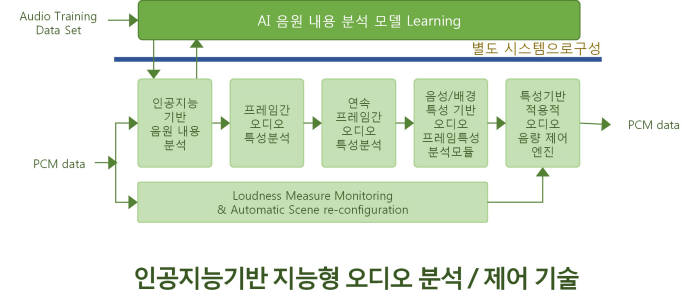

이번에 KETI가 개발한 기술은 이런 불편을 해소하는 것이다. KETI에 따르면 딥러닝을 활용한 CNN(지능신경망의 종류) 알고리즘으로 콘텐츠 내 소리를 400밀리세컨드(1밀리세컨드=1000분의 1초) 단위로 육성, 묵음, 배경음, 혼합음 등으로 구분하고 각 소리에 적합한 맞춤형 음량을 제어한다.

이를 통해 웅얼거리는 듯 들릴 수 있는 대사음량은 키우고 과도한 배경음향은 줄이는 작업이 자동으로 이뤄진다. 기존 콘텐츠 음성 명료도를 개선하고 소리의 상대적 편차를 줄여 편안한 청취 환경을 제공하는 효과를 낼 수 있다. 라이브 방송 시에도 평균음량 규정을 실시간 맞추는데 활용이 가능하다.

김제우 KETI 지능형영상처리연구센터 수석은 “이번 기술개발로 100% 해외 의존 중인 실시간 음량제어 방송장비 국산화가 기대된다”며 “디지털 방송뿐 아니라 인터넷 개인방송, 소셜 미디어 등 퍼스널 미디어 시장에서도 접목할 수 있다”고 말했다.

이 기술은 과학기술정보통신부와 정보통신기획평가원(IITP)의 '방송통신산업기술개발사업'으로 개발이 추진됐다. 현재 주관기관인 네오컨버전스로 기술이 이전돼 사업화가 진행 중이다.

윤건일 전자/부품 전문기자 benyun@etnews.com