인공지능(AI)이 잠재적 위험성과 파괴력에서 21세기의 '핵무기'로 떠오르면서 국가 안보의 주요 수단이자 동시에 위협 수단으로 부상했다.

'AI 킬러로봇' 등과 같은 무인화된 살상무기에 대한 개발, 활용은 최근 우크라이나전을 계기로 논란이 되고 있다. 목표물을 향해 스스로 움직이는 공격용 '무인기(드론)'도 본격적으로 개발·활용되면서 국제사회의 뜨거운 감자가 됐다.

전문가들은 올해 미 대통령 선거를 비롯해 전 세계에서 주요 선거가 치러지면서 생성형 AI 기술이 만들어낸 허위정보가 군사 무기 활용 이상의 파급력을 발휘할 것으로 예측하기도 했다.

기술 패권이 국가 안보로 직결되는 가운데, 미국과 유럽연합(EU), 일본 등 주요국은 인간과 AI의 지속 가능한 발전과 공존이라는 인류 공동의 목표는 물론이고 미래 사회의 경제, 사회, 안보에서의 AI 주도권 확보에 나서고 있다.

◇미국·유럽, AI 법으로 AI 안전성·책임성 강화

AI 안전 정책에 가장 적극적인 곳은 미국이다.

미국은 오픈AI, 구글, 메타 등 빅테크 기업이 거대언어모델(LLM)을 보유하고 있으며, 정부 차원의 AI 기술 표준화와 안전성 강화 조치로 미래 핵심 산업의 주도권을 강화하고 있다.

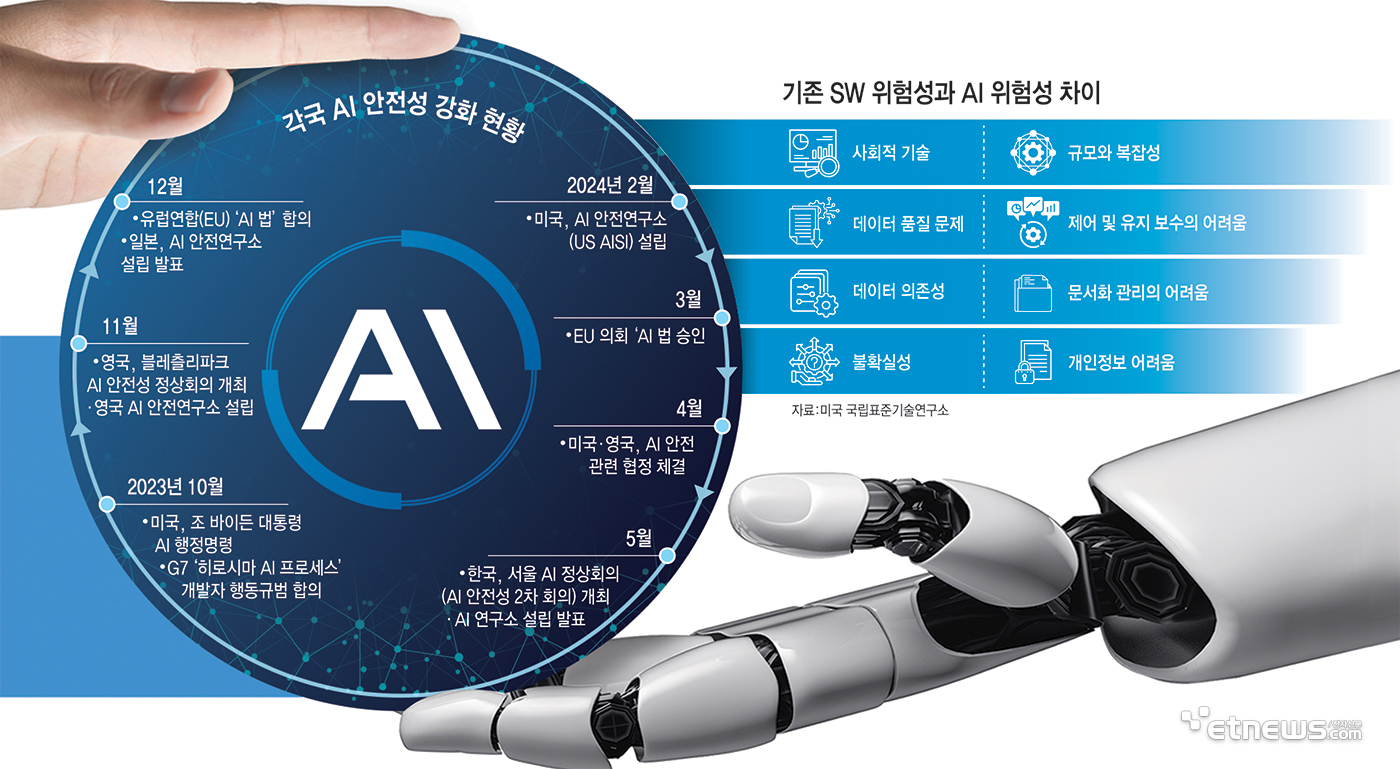

미국은 지난해 10월 조 바이든 미국 대통령이 사실상 AI법에 해당하는 'AI 행정명령'을 발표했고, AI 기술 발전과 함께 긍정적 가능성과 함께 AI가 가진 잠재적 위협, 나아가 군사적 활용에 대한 적절한 규제 및 대응책을 마련하도록 했다.

미국은 올해 2월 AI 안전·보안·신뢰 전담 기관인 '미국 AI 안전연구소(US AISI)'를 설립했다. 미 상무부 국립표준기술연구소(NIST) 내 연구소로 설치돼, 민간 협업을 위한 '컨소시엄(AISIC)'도 구성했다.

미국 AI 안전연구소는 위험한 기능을 평가, 완화하기 위한 지침과 도구, 벤치마크 및 모범사례를 만들고 AI 위험을 식별, 완화하기 위한 평가를 수행한다. 인간이 생성한 콘텐츠 인증, AI 생성 콘텐츠 워터마킹, 유해한 알고리즘 식별과 완화, 개인정보 보호 활동 기술 개발 등을 담당한다.

이는 미국 AI 기업의 기술 안전성을 강화해 사실상 글로벌 표준으로 자리잡도록 지원하는 것이다.

EU는 빅테크 기업을 보유한 미국에 맞서 5월 21일 가장 강력한 AI 규제법으로 불리는 'AI법'을 승인, 올 연말부터 시행을 앞뒀다.

EU는 AI 모델 관련 활용 위험도를 크게 네 단계로 나눠 차등 규제하도록 했다. 특히 의료와 교육, 선거, 자율주행 등에 사용되는 AI 기술은 반드시 사람이 감독하고 위험관리시스템을 구축하도록 했다.

구체적 규제 요구사항, 위반시 부과되는 벌금 등을 담고 있으며 EU 내에서 AI 기술 개발과 사용을 광범위하게 규제한다. 규정을 어길 시 기업은 세계 매출액의 1.5%에서 최대 7%에 달하는 벌금을 내야 한다.

일본도 G7히로시마 AI 프로세스 발표와 AI 안전성 정상회의에 후속조치로 기시다 총리가 지난해 말 일본AI안전연구소 설립 계획을 발표하고, 국제협력 등의 발빠르게 대응하고 있다.

◇우리나라도 AI안전연구소 연내 설립 추진…입법안에도 담겨

우리나라는 작년 11월 영국 블레츨리 파크 회의에서 주요국 정상·기업이 모여 개최한 '제1회 AI 안전 정상회의'에 이어 5월 21, 22일 '서울 AI 정상회의'를 열고 AI 안전 대응 방안을 모색하고 있다. 당시 윤석열 대통령이 미국, 영국에 이어 우리나라도 AI 안전연구소 설립을 추진하겠다고 직접 밝혔다.

AI 서울 정상회의에서 채택된 '서울선언'을 바탕으로 글로벌 AI 안전네트워크에 참여할 AI 안전연구소를 ICT 유관기관 산하 연구소로 연내 설치될 예정이다.

국내에는 아직 AI 법이 없지만, 현재 22대 국회에 발의된 6건의 AI 기본법 등에 이미 안전하고 신뢰할 수 있는 AI 기술·정책의 제도적 기반을 조성하는 내용이 공통적으로 담겨있다.

정점식 국민의힘 의원이 대표 발의한 '인공지능 발전과 신뢰 기반 조성 등에 관한 법률안'에 따르면 과학기술정보통신부 장관이 AI안전연구소를 운영하도록 했다. 이는 AI사회 구현, AI산업 진흥 및 경쟁력 강화에 필요한 업무를 종합적으로 수행하기 위해 조성되는 국가AI센터와는 구별된다.

AI 안전연구소는 AI 기술과 알고리즘의 안전하고 편리한 이용을 위해 △비상정지 기능 구현 △사생활 등의 보호에 적합한 설계 기준 및 기술의 연구개발 및 보급 △사회적 영향평가의 실시와 적용을 위한 연구개발 사업 △AI가 인간의 존엄성 및 기본권을 존중하는 방향으로 제작, 이용될 수 있도록 하는 기술 또는 기준의 연구개발 및 보급사업을 비롯해 교육과 홍보 사업 등을 추진할 수 있다.

◇빅테크도 AI 안전 가이드라인 수립

글로벌 빅테크 기업도 AI 안전성 강화를 위해 기업 개별적으로 안전·윤리 가이드와 AI 안전성 평가체계 등을 만들고 책임있는 AI 기술 개발과 사용을 위한 민·관 협력 등에도 적극적이다.

마이크로소프트, 구글, 오픈AI, 앤스로픽과 같이 AI 모델을 보유한 4개 기업은 지난해 7월 안전하고 책임있는 AI 개발을 위해 '프론티어 모델 포럼' 구성을 발표했다.

AI의 잠재적 위험을 완화하는 모범 사례를 발굴하고 AI 안전 조치에 대한 과학적 연구, 기업과 정부 간 소통을 위한 연구 개발 활동 등을 주요 목표로 제시했다.

또 빅테크 기업은 선거 등에 악용되는 것을 방지하기 위해 생성형 AI 챗봇 서비스에 관련 질문을 막거나 생성형 AI 서비스로 만들어진 이미지나 영상에 자발적으로 워터마크 등을 붙이는 작업도 시작했다.

네이버는 지난달 17일 AI 안전성 실천 체계(ASF)를 공개했다.

AI 시스템이 초래할 수 있는 위험을 정의하고 대응하는 방법을 설계한 것으로 AI 시스템이 인간의 통제를 벗어나는 위험을 완화하고, AI 시스템의 위험을 주기적으로 평가 관리하는 것이 핵심이다.

업계 관계자는 “생성형 AI 모델의 기반이 되는 트랜스포머 모델은 수억개의 매개변수를 바탕으로 매우 복잡한 구조를 지녀 내부적으로 어떤 학습을 거쳐 결과를 도출하는 지 명확한 이해가 어렵다”며 “이러한 AI의 불확실성과 불투명성 때문에 AI 모델의 안전하고 책임있는 활용에 대한 연구개발과 평가기준, 정부의 가이드라인, 나아가 주요국처럼 입법화를 통한 체계적 관리가 필요하다”고 말했다.

※인공지능(AI) 안전성 관련 연표

2023년 10월 미국 조 바이든 대통령 AI 행정명령

2023년 10월 'G7 히로시마 AI 프로세스' 개발자 행동규범 합의

2023년 11월 영국 블레츨리파크 AI 안전성 정상회의 개최, 영국 AI 안전연구소 설립

2023년 12월 유럽연합(EU) 'AI 법' 합의

2023년 12월 일본 기시다 총리 AI 안전연구소 설립 발표

2024년 2월 미국 AI 안전연구소(US AISI) 설립

2024년 3월 EU 의회 AI 법 승인

2024년 4월 미국, 영국 간 AI 안전 관련 협정 체결

2024년 5월 서울 AI 정상회의(AI 안전성 2차 회의) 개최, AI 연구소 설립 발표

※기존 소프트웨어(SW) 위험과 인공지능(AI) 시스템 위험성 차이점

-사회적 기술

-데이터 품질 문제

-데이터 의존성

-불확실성

-규모와 복잡성

-제어 및 유지 보수의 어려움

-문서화 관리의 어려움

-개인정보 어려움

출처:미 NIST 'AI 위험관리 프레임워크(AI RMF) 1.0' 분석 및 시사점(한국지능정보사회진흥원 발간)

김명희 기자 noprint@etnews.com