관련 통계자료 다운로드 빅데이터 증가량

관련 통계자료 다운로드 빅데이터 증가량 고등과학원 박창범 교수는 지난해 우주 거대구조 시뮬레이션을 돌리는데 CPU코어만 8192개를 사용했다. 메모리 필요량만 17테라바이트, 전체 데이터 생성량은 300테라바이트에 달했다. 3750억 입자를 하나하나 계산하는데 들어간 CPU 구동시간은 총 412만 8768시간이나 됐다. 이는 빅데이터 처리의 한 예에 불과하다. 지난 해 전 세계에서 생성 및 복제된 디지털 정보량은 1.8제타바이트(ZB)였다. 2시간짜리 HD급 영화 2000억개와 맞먹는 분량이다. 세상은 이제 기존 방법으로는 어마어마하게 쏟아져 나오는 데이터를 감당하기 어려운 수준에 도달했다. 빅데이터 처리가 제4세대 R&D 패러다임으로 등장한 이유다. 국내에서는 한국과학기술정보연구원이 과학분야 빅데이터 SW플랫폼 연구에 속도를 내고 있다. 어떤 일을 하는지, 문제점과 대안은 무엇이 있는지 찾아봤다.

#1. 1시간 전 서해안 원유 유출 사고가 발생하자 정부는 긴급히 K박사가 참여하는 비상대책 본부를 꾸렸다. 그러나 원유확산 범위를 예측해 당장 보고해 달라는 정부 주문에 K박사는 난감했다. 정확한 예측을 위해서는 사고발생 위치와 해류, 풍향, 해저지형 및 물과 유출된 기름의 물성 데이터 등 다양한 자료가 필요하기 때문이다. 설령 이 자료를 구한다고 해도 이를 분석할 고성능 슈퍼컴퓨터나 가시화 장비 등을 원하는 때 마음대로 이용할 수 없는 상황이었다.

#2. 우리나라 서해안에 인접한 중국 T원전이 원인불명 사고로 방사성 물질을 포함한 증기를 대기 중으로 방출하고 있다는 외신 보도에 따라 긴급히 국가위기상황센터가 발족됐다. 우리나라는 대기 중으로 방출되는 증기와 액체 방류물에 의한 방사성 물질 피폭에 그대로 노출돼 있는 상황이었다. 다급해진 국가위기상황센터가 국내에 미치는 영향을 예측하려고 하니, 실시간 해류 데이터와 해저지형 데이터 등을 구하는 게 쉽지 않았다. 급히 해양연구원과 기상청으로부터 관련 자료가 있다는 것을 알았지만, 데이터 양이 엄청나 전송받아 변환하는 데만 1개월도 더 걸린다는 걸 알고 포기했다.

하지만 이 같은 업무가 빅데이터 공유 및 관리 시스템이 있을 경우는 상황 대처가 완전히 달라진다. K박사는 먼저 위성사진을 통해 사고 발생 지점의 위·경도를 파악하고, 최근 10년간 해류 및 풍향 정보, 기름과 물의 물성 데이터를 단숨에 받아 볼 수 있다. 해류 및 풍향 데이터는 모두 고해상도 3D 데이터로 온도 및 압력 등 다양한 정보가 함께 제공되기 때문이다. 이 데이터는 국가과학데이터 공유·융합센터의 분산·병렬컴퓨터에서 예측 시뮬레이션으로 실시간 가시화됐다. K박사는 프로그램을 실행하자마자 현장 노트북 웹 브라우저를 통해 기름 확산 범위를 예측하고 즉시 해당 지역에 기름막 펜스 설치를 요청했다.

두번째 사례도 마찬가지다. 관련 어종과 서식수층, 어종에 대한 피폭 모니터링, 과거 30년간의 서해안 풍향, 풍속, 대기안정도 등과 같은 기상자료와 위성 자료를 대기 확산 모델에 적합한 형태로 변환하는데 걸리는 시간외에는 거의 실시간에 가깝게 국내 영향의 정도를 파악할 수 있다.

물론 이 모든 예상치는 국가과학데이터 공유·융합체제가 구축됐을 때의 얘기다.

◇어떤 일을 하나= 3년 전부터 빅데이터 관련 기술 개발을 준비해온 한국과학기술정보연구원(KISTI, 원장 박영서)은 고성능 과학기술 빅데이터 SW 플랫폼 개발에 본격적으로 뛰어들었다. 빅데이터를 운용하고 활용하기 위한 고성능 컴퓨팅 기반 체제를 마련하기 위함이다.

전체 사업 기간은 오는 2013년부터 2021년까지 총 9년이다. 예산은 1단계 기반 조성기(2013~2015)에 135억원을 투입할 계획이다. 2단계인 성과창출기(2016~2018)와 3단계인 성과확산기(2019~2021)에 각각 42억 5000만원 등 총 220억원을 투입할 계획이다.

과학분야 빅데이터 시스템을 구축중인 KISTI는 먼저 극지연구소와 손을 잡았다. 극지 기후변동 연구를 지원할 빅데이터 처리 기술부터 개발하기로 했다. 예산은 내년에 45억 원을 투입하기로 했다. 목표는 과학기술 빅데이터 분석을 위한 프로토타입 개발이다.

극지연구소 측은 고정밀, 대용량 위성사진 500만장 정도를 처리하는 수준이 될 것으로 예상했다. 현재 영상 1장당 처리 시간은 7분이다. 만약 500만장을 처리한다고 가정하면 무려 72년이 소요된다.

이어 2018년까지 과학기술 빅데이터 분석 플랫폼을 개발하고, 이를 2021년까지 기후예측 모델과 융합할 계획이다.

세계최고 대비 기술수준은 오는 2018년까지 빅데이터 분산처리 기술과 분석 및 응용 플랫폼 부문 등에서 최대 95%까지 따라 잡을 것으로 예상했다.

현재 국내 빅데이터 관련 기술 수준은 세계 최고 대비 50~60% 수준에 머물러 있다.

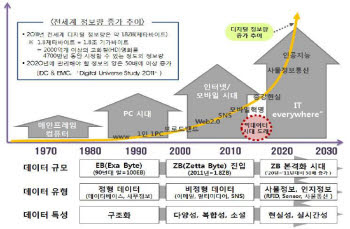

◇왜 필요한가= 스마트 단말이나 M2M 센서, 연구 장비 첨단화로 인해 데이터 양이 급격히 증가했다. 데이터 크기뿐만 아니라 유형(텍스트, 이미지, 동영상 등)에 있어서도 기존 데이터 처리 기술 및 도구의 한계를 가져왔다.

과학기술 분야에서도 생물, 환경, 천문, 국방 등을 연구하는 과학자가 빅데이터를 처리할 수 있는 정보 기술을 확보하지 못해 데이터 전송, 분석, 통합 등을 다루는 데 많은 어려움을 겪고 있는 실정이다.

실례로 극지연구소는 위성사진 상 해수면 색상을 분석해 해양 생태계 및 기후 변화를 분석하고 예측하는 업무를 위해 시간 당 수십 기가바이트(GB) 규모의 데이터를 처리해야 한다. 기존 방법으로는 현실적으로 대처가 어렵다.

◇풀어야할 과제= 데이터가 커지면서 발생한 문제점도 많다. 모든 분야에서 과학데이터의 생산 및 수집에 비용과 시간이 많이 소요된다. 데이터양이 많아지다 보니, 개별 관리가 어려워졌다. 많은 비용과 시간이 투자된 과학데이터가 개인이나 특정 조직에 의해 독점되면서 중복투자나 유사연구 반복의 문제도 초래했다.

데이터가 필요한 연구자에 즉각 제공되지 않아 융합연구 기회가 상실된다는 지적도 제기됐다.

지난해 사이언스가 낸 특집호에 따르면 조사대상 연구자의 48.3%가 1기가바이트 이상의 데이터를 활용했다. 12.1%는 100기가바이트~1테라바이트의 데이터를 다루는 것으로 조사됐다. 또 1테라바이트 이상 사용자도 7.6%나 됐다.

중복 실험에 따른 예산 손실액도 미국의 경우 매년 10억 달러에 이르는 것으로 추정됐다. 우리나라도 해마다 800억 원 정도가 중복투자로 인해 예산손실을 입는 것으로 예상됐다.

◇누구와 협력하나= 당장은 극지연구소 기후예측을 연구하는 과학자 그룹과 협력해 고층대기 변화에 기인한 기후변동성에 대한 연구를 통해 정밀한 미래 시나리오를 제작할 계획이다.

KISTI는 고성능 컴퓨팅 자원을 제공한다. 현재 KISTI는 기관방문을 통해 과학데이터 관리와 활용에 필요한 수요를 조사·분석 중이다.

KAIST와 한국전자통신연구원, 델라웨어 대학, 한국해양연구원, 제주대학교, 디지털다임, 아르고넷을 비롯한 18개 기관 및 기업이 이 사업에 참여했다.

KISTI 관계자는 “2020년쯤이면 관리해야할 정보 양이 현재의 50배인 90제타 바이트는 될 것으로 예상한다”며 “빅데이터 처리는 향후 과학기술계의 사활이 걸린 문제가 될 것”이라고 말했다.

대전=박희범기자 hbpark@etnews.com