빅테크 기업들이 에너지와 비용이 적게 드는 경량형 거대언어모델(sLLM) 개발에 속도를 내고 있다.

모델 성능은 높이고 비용은 낮춰 기업 고객의 멀티 LLM 전략에 대응하기 위해서다.

페이스북 모회사 메타는 지난 달 4050억개 매개변수를 가진 LLM '라마 3.1'을 선보였다. 현존하는 가장 큰 오픈소스 모델로, 여러 벤치마크에서 오픈AI 'GPT-4o' 대비 인프라 비용은 절반이면서 더 뛰어난 성능을 자랑한다.

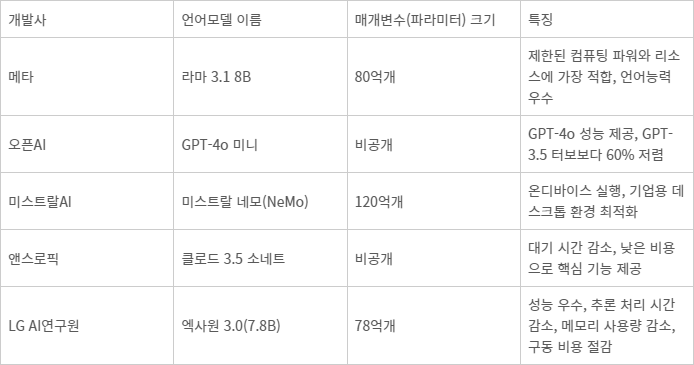

메타는 매개변수가 700억개인 중형 모델 '라마3.1 70B', 80억개인 소형 모델 '라마3.1 8B'을 함께 선보였다. 성능은 높이고 비용은 줄인 것이 핵심이다.

오픈AI는 이보다 약 일주일 앞서 소형 모델 'GPT-4o 미니'를 출시했다. GPT-4o 미니는 GPT-4o의 성능을 효율적으로 제공하면서 비용은 'GPT-3.5 터보'보다 60% 저렴하다.

프랑스 AI 스타트업 미스트랄AI도 엔비디아와 협력해 '미스트랄 네모(NeMo)'를 출시했다. 120억개 매개변수로 퍼블릭 클라우드가 아닌 기업용 데스크톱 환경에서 실행 가능한 온디바이스 AI 모델이다.

앤스로픽이 지난 6월 출시한 '클로드 3.5 소네트'는 최상위 모델 '클로드 3 오푸스'보다 더 작은 모델로 대기 시간을 줄이고 낮은 비용으로 핵심 기능을 제공한다.

국내에서는 LG AI연구원이 지난 7일 매개변수 78억개의 소형언어모델 '엑사원 3.0(7.8B)'을 오픈소스로 공개했다. 지난해 7월 공개한 '엑사원 2.0'에 비해 추론 처리 시간은 56%, 메모리 사용량은 35% 줄였다. 구동 비용은 72% 절감했고 성능은 '라마 3.1 8B'나 '큐원 2 7B' '미스트랄 7B' 등을 능가한다.

고객사 입장에서는 더 낮은 비용으로 선택하고 활용할 수 있는 AI 모델이 더욱 다양해졌다.

대기업이나 금융권 등은 데이터 보안 등을 이유로 여전히 온프레미스(구축형)으로 경량형 AI 모델 개발을 선호한다. 이때 매개변수가 큰 AI 모델을 미세조정해 사용하려면 컴퓨팅파워와 대기시간이 늘어나는 단점이 있어 sLLM에 관심이 높다.

AI 모델 개발사 입장에서도 경량화는 중요하다. 오픈AI는 챗GPT 운영에만 매일 약 70만달러(약 9억 6000만원)을 지출하는 것으로 알려졌다. 더 작은 모델을 개발하면 이러한 인프라 비용을 낮출 수 있다는 분석이다.

국내 AI기업 대표는 “현재는 기업들이 다양한 LLM을 테스트하는 단계”라며 “효율적으로 AI 전환을 하려는 기업 요구에 맞춰 다양한 AI 모델이 경쟁하는 구도가 펼쳐질 것으로 예상된다”고 말했다.

김명희 기자 noprint@etnews.com