2022년에 등장한 챗GPT는 생성형 인공지능(AI) 열풍을 일으켜 정보통신기술(ICT) 분야를 넘어 자동차, 의료, 교육 등 다양한 산업으로 확장하며 우리의 삶을 변화시키고 있다.

이와같이 다양한 영역에서 AI 기술이 활용되면서 AI 데이터 처리량은 급증하고 있으며, 미래 산업에서는 무한대에 가까운 데이터 처리를 위해 클라우드 시스템이 변화하고 있다.

기존 클라우드 시스템에서는 중앙처리장치(CPU)가 주로 연산을 담당했지만, AI의 등장으로 그래픽 처리장치(GPU)가 중요성을 갖기 시작했다.

데이터 처리량 증가는 메모리 반도체의 중요성을 더욱 높였다. 메모리는 CPU와 GPU가 데이터를 처리하기 위한 저장소 역할을 한다.

따라서 메모리의 용량과 대역폭이 충분하지 않으면 데이터 처리 속도가 저하될 수 있다. 이를 해결하기 위해 데이터 처리 속도를 높이거나 통신을 활성화하는 방법으로 한계 극복 시도에 나서고 있다.

최근 막대한 양의 AI 작업을 수행하기 위해 데이터 처리 속도를 향상시킨 고대역폭메모리(HBM)에 이어 D램의 확장성을 무기로 삼은 CXL(Compute Express Link)이 메모리 업계 최대 화두로 떠오르고 있다.

HBM은 D램 칩을 수직으로 쌓아 올린 구조로 짧은 전송 경로로 인해 데이터를 빠르게 전송하고, 전력소비도 줄일 수 있어 현재 AI에 최적화된 메모리로 주로 AI 연산을 위한 GPU에 탑재된다.

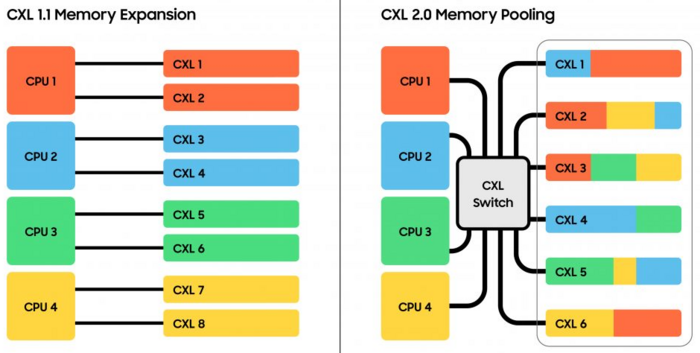

HBM의 기술발전과 더불어, 고속의 데이터 처리를 위해 등장한 것이 CXL(컴퓨트익스프레스링크)이다. HBM이 여러 개의 D램을 연결해 연산 속도를 끌어올린 '제품'이라면, CXL은 메모리 용량을 유연하게 확장하는 '기술'이다.

CXL은 메모리 및 가속기 장치와 프로세서 간 데이터 통신을 위한 새로운 표준으로, 컴퓨팅 시스템의 중요한 부품인 CPU, GPU, 저장장치 등을 연결하는 차세대 인터페이스다.

기존에는 CPU를 중심으로 메모리와 저장장치 등 각 장치에 별도 인터페이스가 존재해 각 장치 간 통신을 할 때 다수의 인터페이스를 통과하는 과정에서 지연 문제가 발생했다.

특히 AI, 머신러닝 등 데이터 처리량이 폭발적으로 증가하며 이런 지연 문제는 더욱 심화됐다.

CXL은 다수의 메모리 반도체를 연결해 거대한 공용 메모리 풀(pool)을 형성하는 기술로 서버 구조를 바꾸지 않고도 메모리 용량을 늘릴 수 있다.

CXL은 기존 시스템의 메모리 인터페이스보다 더 높은 대역폭과 더 낮은 지연시간을 제공한다. 이는 데이터 전송 속도를 크게 향상시켜, 메모리 병목 현상을 해결하는 데 도움이 된다.

또한 CXL은 탈부착이 가능해 호환성과 확장성 면에서 우수하다.

이는 다양한 시스템 및 디바이스 간의 연결을 원활하게 지원하고, 시스템의 구성을 유연하게 변경할 수 있도록 한다.

다양한 기업이 CXL을 활발히 도입할 예정이며, 특히 대용량의 데이터 처리 및 고성능 컴퓨팅 분야에서의 사용이 더욱 확대될 예정이다.

클라우드 서비스, 데이터 센터, AI, 그리고 빅데이터 분야에서 CXL 활용이 확대될 것으로 예상된다.

시장조사업체 가트너는 AI 반도체 매출이 2023년 534억달러(약 70조원)에서 2027년 1194억달러(약 156조원) 규모로 성장할 것으로 전망했다.

비록 CXL은 아직 초기 단계에 있지만, 지속적인 기술 발전과 함께 새로운 혁신을 이끌어낼 것으로 기대된다.

새로운 응용 분야에서의 도입과 향후 표준화를 통해 CXL은 데이터 처리 및 전송 분야에서 더욱 중요한 역할을 수행할 것으로 예상되며, 이는 기업들이 데이터 중심 시스템을 효율적으로 운영하고 경쟁력을 강화하는 데 도움이 될 것이다.

고은영 정보통신기획평가원(IITP) 연구위원