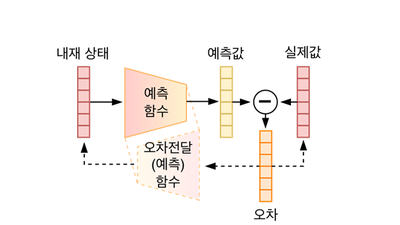

인공지능(AI)도 만능은 아니다. 데이터 학습 과정에서 편향된 정보, 특정 가치와 결합된 정보가 포함될 경우 종종 편견이나 심각한 오류가 발생한다. 최근 이런 AI 편견을 잡아내는 소프트웨어(SW) 도구가 개발됐다.

IBM은 최근 AI 의사결정 과정에서 편견을 파악하고 조정을 권고하는 '페어니스 360(Fairness 360)' 키트를 공개했다. AI 기술이 의도치 않게 여성과 소수자 등 특정 집단을 차별할 가능성을 줄이는 데 도움을 주기 위해 이 도구를 개발했다.

이미지 인식, 번역 등 AI 기술은 기계학습 과정에서 적절치 못한 데이터 선정, 연구팀 내 다양성 부족 등 이유로 편견이 포함될 수 있다.

AI 활용으로 특정 그룹에 대출이 거절되거나, 백인 사용자와 소수 그룹 간 동일하게 AI가 작동하지 않을 때 기업들은 사회적 비난을 받았다. 마이크로소프트(MS)와 IBM 안면 인식 기술이 어두운 피부 여성보다 밝은 피부 남성 얼굴을 더 정확하게 식별한다는 비판 등이 대표 사례다. 두 회사는 이후 기술 개선으로 오류를 줄인 것으로 알려졌다.

AI 오류를 줄이는 검사 도구는 IBM뿐 아니라 구글, MS 등 다양한 글로벌 기업이 개발하고 있다. 구글도 최근 유사한 도구를 발표했으며 MS도 5월 AI 오류 검사 도구를 출시할 계획을 밝혔다.

오대석기자 ods@etnews.com