광주과학기술원(GIST·총장 임기철)은 김선동 인공지능(AI)융합학과 교수팀이 거대언어모델(LLM)의 추론 능력을 정량적으로 측정할 수 있는 새로운 프레임워크를 개발했다고 13일 밝혔다.

연구팀은 인간의 인지 과정이 '사고 언어'로 매개된다는 인지심리학의 '사고 언어 가설(LoTH)'을 기반으로 LLM의 추론 과정을 평가하는 방법을 제시했다.

인간의 추론 과정은 △논리적 일관성 △구성성 △생성성의 세 가지 특징을 가진다. 이 세 가지 요소에 초점을 맞춘 연구팀은 벤치마크 데이터세트 ARC(AI2 Ressoning Challenge)를 통해 프로세스 중심 방식으로 LLM의 추론 및 문맥 이해 능력을 평가하는 새로운 접근 방식을 도출했다. 또 논리적 일관성을 측정하기 위해 LLM이 문제를 해결할 때 일관된 정답을 도출하는지를 실험했다.

연구팀은 동일한 문제를 변형한 '증강 문제를 만들어 LLM이 변형된 문제에서도 동일한 논리를 유지하는지를 분석했다. LLM의 논리적 일관성이 프롬프팅 방법*에 따라 차이를 보인다는 점을 확인했다.

이어 구성성(조합 능력)을 평가하기 위해 LLM이 문제를 해결하는 데 필요한 개념들을 얼마나 효과적으로 조합하는지를 실험했다. 전체 과정을 고려해 개별 개념을 조합하는 인간에 비해 LLM은 조합해야 할 단계가 많아질수록 정확도가 떨어지는 모습을 보였다.

연구팀은 LLM의 생성성을 평가하기 위해 제약 조건에 맞는 유효한 결과를 얼마나 많이 생성하는지를 실험했다. ARC 문제를 여러 개의 카테고리로 나누고, 역방향의 새로운 프롬프팅 방식을 제시했다. LLM의 추론 능력을 과정 중심으로 분석하는 실험법을 제시했으며 이 과정에서 LLM뿐만 아니라 추론 AI 개발에 필요한 LLM을 활용한 프로그램 합성법, 프롬프팅 기법을 통한 데이터 증강법 등을 제안했다.

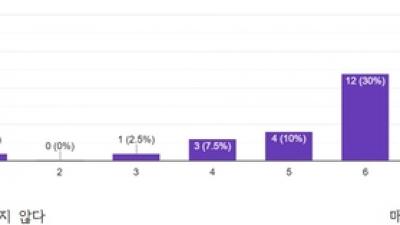

LLM의 추론 능력을 정량적으로 측정한 결과, 논리적 일관성 부문에서 증강(변형) 문제에 대해 평균 18.2%의 정확도를, 구성성 부문에서 조합 과제에 대해 5~15%의 정확도를, 생성성 부문에서는 17.12%의 생성 타당도를 보였다.

연구팀은 LLM이 일부 추론 능력을 보이지만 계획 단계가 길고 입출력 이미지가 복잡해지면 단계적인 추론을 거치지 못해 논리적 일관성, 구성성, 생성성 등 세가지 측면에서 한계를 보이며 인간과 비교했을 때 추론 능력은 여전히 뒤쳐져 있다고 설명했다.

김선동 교수는 “이전의 LLM 평가 방식이 특정 벤치마크에 의한 성능 측정에 치중한 반면, 이번 연구는 LLM의 추론 과정과 인간의 차이를 분석한 것이 특징”이라며 “향후 AI 로봇을 비롯한 인공지능 시스템이 인간 수준의 추론 능력을 갖추는 데 기여할 것으로 기대한다”고 말했다.

광주=김한식 기자 hskim@etnews.com