스타트업 소이넷이 기존 머신러닝 엔진 대비 처리 속도는 3배 이상 빠르면서 사용 메모리는 9분의 1 이상 낮추는 독자 기술을 앞세워 인공지능(AI) 실행 가속기 시장 공략에 팔을 걷어붙였다. AI 실행가속기는 이미 학습된 추론 모델을 서비스 단계에 실제 적용하기 위한 머신러닝 엔진이다.

특히 회사는 현재 구글·엔비디아·인텔 등 AI 반도체(FPGA·ASIC) 기반의 AI 실행 가속기가 글로벌 시장 주도권을 다투는 구도속에서 SW 기반의 AI 실행 가속기로 틈새 시장 개척에 나선다.

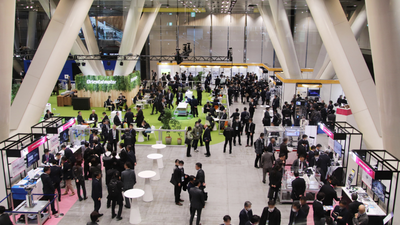

소이넷(대표 김용호·박정우)은 AI 실행 가속기플랫폼 '소이넷 2.0' 버전을 출시하고 삼성동 코엑스에서 19일 열리는 '2018 ICT 이노페스타'에 참가해 AI 실행 가속기를 소개한다.

회사는 GPGPU 기술인 쿠다(CUDA) 기반의 '소이넷 1.0' 버전을 지난 6월 선보인 데 이어 엔비디아 텐서 RT를 지원하면서 성능을 50% 이상 향상한 '소이넷 2.0'버전을 단기간에 내놓았다.

'소이넷 2.0'은 벤치마킹(YOLOv3/GTX1080TI) 결과에서 학습된 추론 모델 테스트 속도를 텐서플로우, 파이토치, 카페 등 기존 머신러닝 엔진에 비해 3배 이상 가속화시킨다. 이는 기존 머신러닝 프레임워크와 달리 학습 기능을 제거하고 추론 기능만 빠른 속도로 가속 수행하기 때문이다.

또 AI 추론 모델을 실행할 때 학습 모델에 사용된 역전파 알고리즘 같은 무거운 모듈이 메모리를 점유하지 않아 메모리 사용량이 9분의 1 이상 줄어드는 효과를 가져올 수 있다. 텐서플로우, 파이토치 등 기존 머신러닝 엔진은 학습 기능과 실행 기능을 통합한 프레임워크 구조여서 고성능 서버를 필요로 한다.

소이넷은 적지 않은 개발비와 장시간이 들어가는 AI반도체 기반의 AI 실행 가속기 시장에서 소이넷 2.0으로 AI 응용애플리케이션 개발 생산성을 제고하고 HW 투자 가성비와 AI 모델 범용성 문제를 해결, 새로운 수요를 개척할 계획이다.

소이넷은 이미지 탐지·분류를 위해 비전검사 방식에서 딥러닝으로 전환하는 데 있어 추론 모델 실행 속도 지연으로 실제 현장에 적용하는데 어려움을 겪는 대기업을 대상으로 공략한다. 속도와 모델 앙상블(복수조합)로 인한 메모리 투자 문제로 어려움을 겪는 자연어 처리 분야로도 영역을 확장할 계획이다.

엄동원 상무는 “소이넷은 1MB 정도로 매우 가벼운 엔진이며 학습된 추론모델 실행을 위한 5개의 간단한 API 구조를 제공하기 때문에 최근 대형 SI 회사와 기존 IT 인력을 활용한 AI 응용 서비스 개발을 위한 모델로 제안하고 있다”고 말했다.

안수민기자 smahn@etnews.com