AWS 리인벤트 2024서 공개

노바, 200개 이상 언어 지원

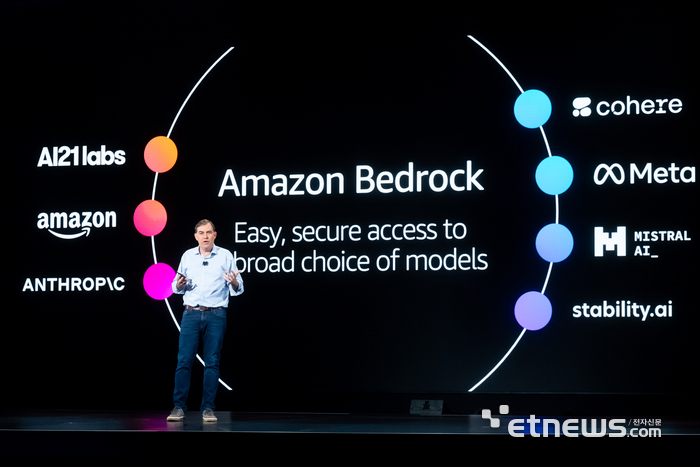

AWS 베드록으로 제공 방침

트레이니움3, 3나노 공정 칩

전작보다 성능 2배·효율 40%↑

아마존과 아마존웹서비스(AWS)가 각각 생성형 인공지능(AI) '노바'를 출시하고 차세대 AI 칩 '트레이니움3' 개발 계획을 발표하는 등 AI 시장 주도권을 잡기 위한 고삐를 당겼다.

특히 AWS는 생성형 AI 개발 플랫폼과 이를 활용한 애플리케이션 레벨에도 AI 활용을 강화하며 AI 전 분야에서 경쟁력을 강화했다.

3일(현지 시간) 미국 라스베이거스에서 열린 '아마존웹서비스(AWS) 리인벤트 2024'에서 앤디 재시 아마존 최고경영자(CEO)는 기조연설자로 나서 노바를 공개했다.

노바는 AI 파운데이션 모델(FM)로 △마이크로 △라이트 △프로 △프리미어로 구성됐다. 200개 이상 언어를 지원한다.

마이크로는 경쟁사인 메타의 오픈소스 LLM '라마'의 경량화 모델 '라마 3.1 8B'와 경쟁한다. 텍스트만을 이해한다.

반면에 라이트, 프로, 프리미어는 전부 멀티모달 모델이다. 텍스트와 이미지를 동시에 처리할 수 있다. 이 중 라이트와 프로는 오픈AI의 GPT 4o 미니, GPT-4o와 경쟁한다.

재시 CEO는 “새로운 최첨단 기술인 노바 출시를 공유하게 돼 기쁘다”며 “단 하나의 (생성형 AI) 모델이 세상을 지배하는 일은 없을 것”이라고 밝혀 치열한 경쟁을 예고했다.

아마존은 노바를 AWS의 AI 구축 도구 '아마존 베드록'을 통해 제공할 방침이다. 노바 마이크로와 라이트, 프로를 바로 공급하고 프리미어는 내년 1분기까지 제공할 예정이다.

이 외에도 아마존은 각각 고품질 이미지와 비디오를 생성하는 노바 캔버스와 노바 릴을 출시한다.

맷 가먼 AWS CEO는 차세대 생성형 AI 워크로드 성능을 충족하는 3나노 공정의 '트레이니움3'를 공개했다. 여기에 64개의 트라이니엄2 칩을 연결한 울트라서버도 선보였다.

가먼 CEO는 “트레이니움3의 컴퓨팅 성능은 트레이니움2와 비교해 2배 향상되고 효율성은 40% 높아질 것”이라며 “고객은 더 좋은 생성형 AI를 만들 수 있을 것”이라고 말했다.

AWS는 트레이니움3를 내년 말까지 개발할 계획이다.

가먼 CEO는 아마존 베드록의 신규 기능과 이를 이용해서 빠르고 쉽게 생성형 AI 애플리케이션을 구축·배포할 수 있는 차세대 '아마존 세이지메이커'도 공개했다.

아마존 베드록의 신규 기능에는 △AI 모델의 할루시네이션(환각) 오류를 방지하는 생성형 AI 안전장치 '자동화 추론' △고객이 여러 AI 에이전트를 손쉽게 구축하고 오케스트레이션 하도록 돕는 '다중 에이전트' △대규모 고성능 AI 모델을 작고 효율적인 모델로 이전해서 비용을 크게 줄여주는 '모델 증류' 등이 포함됐다.

차세대 아마존 세이지메이커는 고객이 필요로 하는 고속 SQL(구조화 질의 언어) 분석과 페타바이트 규모의 빅데이터 처리, 데이터 탐색과 통합, 모델 개발 및 학습, 생성형 AI 기능을 하나의 통합 플랫폼으로 결합했다.

가먼 CEO는 “혁신을 위해 중요한 것은 고객에서부터 시작된다는 것”이라며 “항상 고객이 무엇을 중요하게 생각하는지 묻고, 해결하는 것이 AWS의 가치”라고 강조했다.

라스베이거스(미국)=류태웅 기자 bigheroryu@etnews.com